Wat is robots.txt?

Geef aan welke pagina’s zoekmachines mogen bezoeken

Een robots.txt bestand is:

Een robots.txt-bestand is een tekstbestand op de server van een website. Het geeft aan welke pagina’s wel of niet bezocht mogen worden door de automatische robots van zoekmachines als Google en Bing.

Een robot is in dit geval software die automatisch pagina’s bezoekt om te lezen wat er op die pagina staat. Een robot wordt ook wel bot, webcrawler, crawler of spider genoemd.

Een zoekmachine als Google gebruikt robots om je pagina te lezen en te begrijpen. Daarnaast vinden zoekmachines met robots nieuwe pagina’s en waarderen ze deze via de links die deze robots tegenkomen. Dit noemen we crawlen.

Waar lijkt robots.txt op?

Je kunt een robots.txt bestand vergelijken met een instructiebordje. Mag de robot een pagina niet zien, dan werkt een robots.txt-bestand dus als een “Geen-toegang”-bordje.

Dit is handig als bepaalde delen van de website niet bedoeld zijn voor publieke weergave, zoals de back-end waarmee je je website zelf beheert.

Waar gebruik je Robots.txt voor?

Met een robots.txt bestand geef je duidelijkheid aan zoekmachines wat wel en wat niet bezocht mag worden. Zo hoeft deze zoekmachine ook geen energie te verspillen aan het in kaart brengen van gedeeltes van je website die toch nooit in de index gaan terugkomen.

De robots.txt is te vinden op [jouwwebsite.nl]/robots.txt.

Via een FTP programma kun je toegang krijgen tot bestanden op je server, waaronder ook het robtos.txt bestand.

Voorbeeld van een robots.txt bestand

Een robots.txt bestaat ziet er voor WordPress websites standaard als volgt uit:

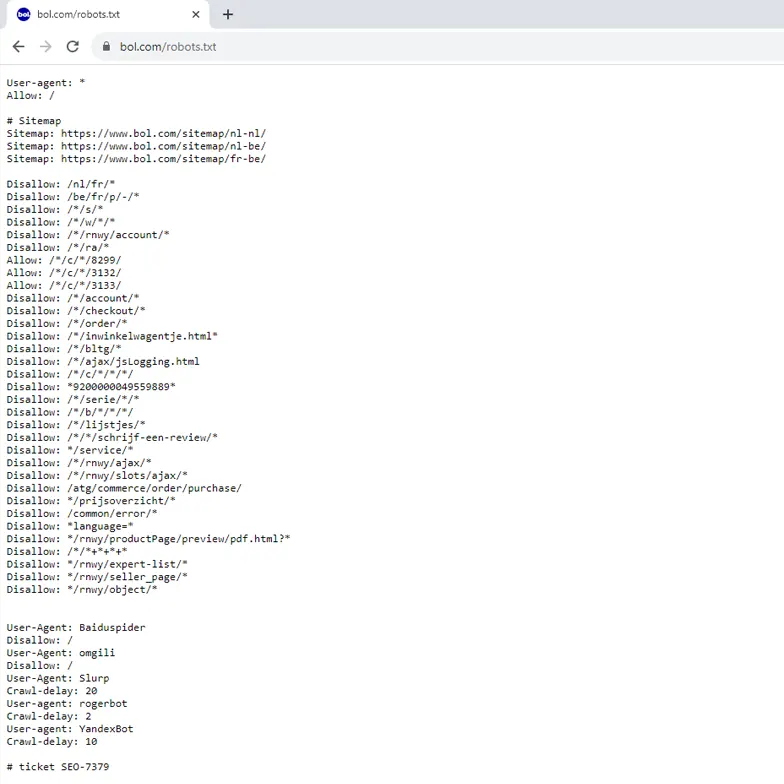

De robots.txt van een grote site als Bol.com ziet er zo uit:

Waarom is een robots.txt bestand belangrijk?

Het robots.txt-bestand helpt om te voorkomen dat een website overbelast raakt. Als robots regelmatig op de website komen om de inhoud te zien, dan moet de server dat ook verwerken.

Bij hoge aantallen kan dit betekenen dat de website trager wordt voor bezoekers. Of er is extra servercapaciteit nodig. Dit zorgt dus voor hogere kosten.

In de praktijk is dit voor de meeste websites niet aan de orde. Laat daarom in de meeste gevallen de robots.txt op de standaard instellingen staan.

Een robots.txt wordt vooral gebruikt om duidelijkheid te geven over welk gedeelte van de website niet bezocht mag worden door automatische robots en van welke zoekmachines.

Bijvoorbeeld:

- Onbelangrijke of dubbele webpagina’s

- Een script met een oneindig aantal URL’s, zoals een kalender

- Pagina’s die gebruikt worden om je content te beheren (zoals WP-admin)

- PDF-bestanden of andere documenten

- Media-bestanden als afbeeldingen, video en audio

- Onbelangrijke scripts

- Onbelangrijke styling-bestanden

“Het robots.txt-bestand helpt om te voorkomen dat een website overbelast raakt.”

Daarnaast kun je er mee voorkomen dat zoekmachines een pagina indexeren. Dit is met de robots.txt methode alleen niet zeker.

Een pagina die niet doorzocht mag worden volgens robots.txt kan nog steeds geïndexeerd worden. Dit komt omdat Google links vanaf andere websites gebruikt om pagina’s te vinden en te indexeren.

Als je wilt dat een pagina niet opgenomen wordt in de zoekresultaten, dan is de no-index-tag de aanbevolen manier.

Hoe gebruik je een robots.txt bestand?

Google begrijpt de volgende commando’s in een robots.txt-bestand:

| Robots.txt regel | Uitleg |

|---|---|

user agent |

Geeft aan voor welke crawler de regels gelden |

allow |

Een URL-pad die bezocht mag worden |

disallow |

Een URL-pad die niet bezocht mag worden |

sitemap |

Een complete URL van een sitemap |

SEO problemen met robots.txt

Veelvoorkomende problemen met canonical tags zijn:

- De website heeft geen robots.txt-bestand

- Het robots.txt bestand is verkeerd opgegeven, bijvoorbeeld een verkeerde locatie of gebruik van hoofdletters

- Pagina’s die doorzocht moeten worden staan of disallow

- Webcrawlers die de website mogen bezoeken staan op disallow

- Een pagina die op disallow staat en daarna op noindex wordt gezet, blijft in de zoekresultaten. Zoekmachines kunnen namelijk de noindex tag dan niet lezen.

Problemen met je robots.txt vind je als je een Site Audit uitvoert.

Nils van der Knaap

Senior SEO Specialist

Nils vreet SEO artikelen als snoepbanaantjes. Met ruim 16 jaar intensieve ervaring als online marketeer en SEO specialist weet hij als geen ander wat werkt en wat niet.

Bekend van